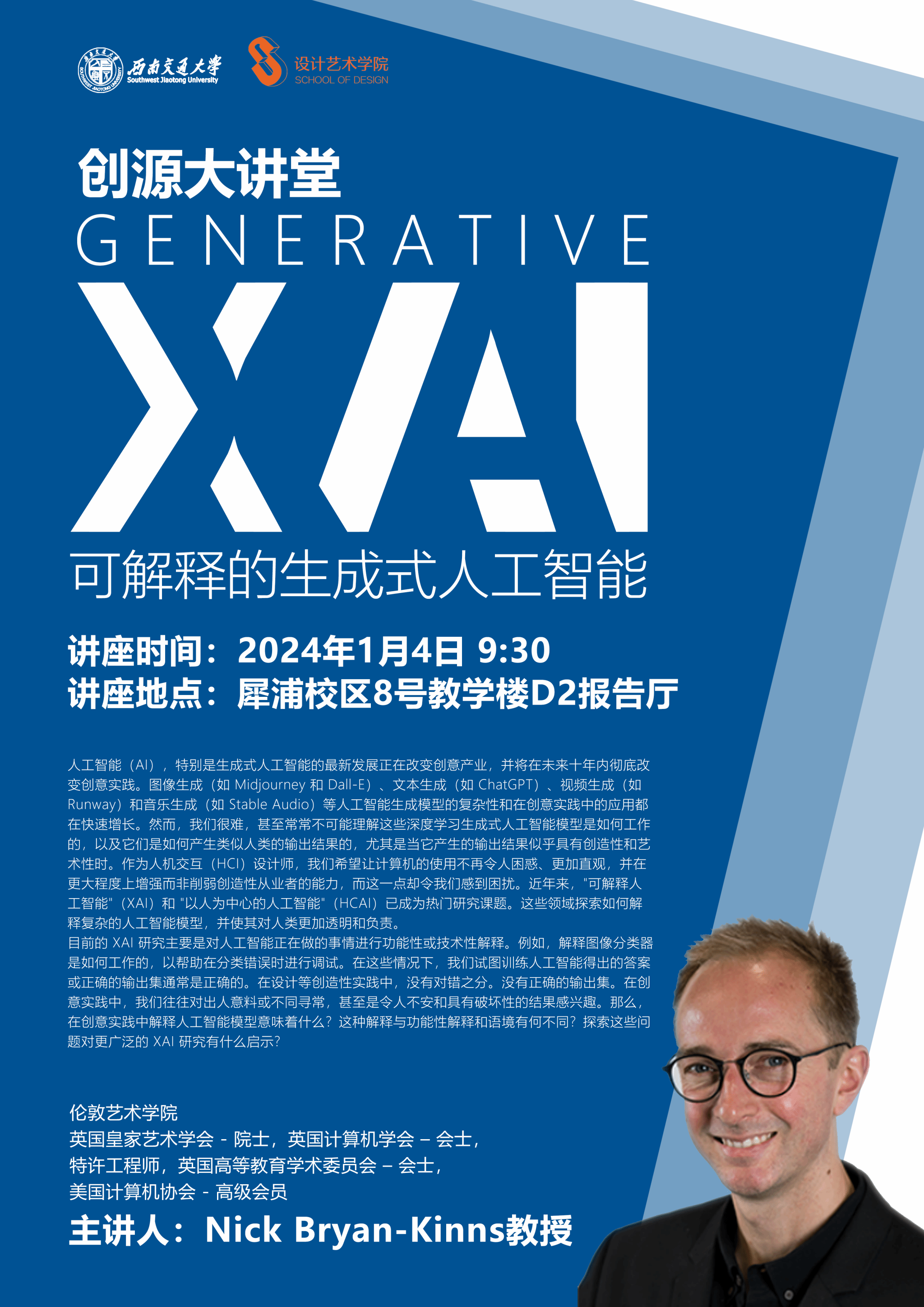

时间:2024年1月4日 9:30

地点:犀浦校区8号教学楼D2报告厅

主讲人:

Nick Bryan-Kinns是伦敦艺术大学教授,获人机交互博士学位,现任英国皇家艺术学会院士、英国计算机学会院士、计算机协会(ACM)高级成员、英国国家科学基金会的创意基金资助小组的成员。Bryan-Kinns教授发表了90余篇国际期刊和会议论文,内容涉及在参与式设计、协作、互动艺术、跨模式互动和有形界面方面的用户体验研究,互动艺术作品在BBC等媒体、伦敦科学博物馆等场所展出。他是ACM创意与认知系列会议指导委员会主席,也是ACM创意、认知与艺术社区的创始主席,他主持了2009年ACM创意与认知会议,并联合主持了2006年英国计算机学会(BCS)国际人机交互会议,获得了ACM和BCS服务奖,以及2015年和2017年QMUL公共参与奖。

讲座内容简介:

人工智能(AI),特别是生成式人工智能的最新发展正在改变创意产业,并将在未来十年内彻底改变创意实践。图像生成(如 Midjourney 和 Dall-E)、文本生成(如 ChatGPT)、视频生成(如 Runway)和音乐生成(如 Stable Audio)等人工智能生成模型的复杂性和在创意实践中的应用都在快速增长。然而,我们很难,甚至常常不可能理解这些深度学习生成式人工智能模型是如何工作的,以及它们是如何产生类似人类的输出结果的,尤其是当它产生的输出结果似乎具有创造性和艺术性时。作为人机交互(HCI)设计师,我们希望让计算机的使用不再令人困惑、更加直观,并在更大程度上增强而非削弱创造性从业者的能力,而这一点却令我们感到困扰。近年来,"可解释人工智能"(XAI)和 "以人为中心的人工智能"(HCAI)已成为热门研究课题。这些领域探索如何解释复杂的人工智能模型,并使其对人类更加透明和负责。

目前的 XAI 研究主要是对人工智能正在做的事情进行功能性或技术性解释。例如,解释图像分类器是如何工作的,以帮助在分类错误时进行调试。在这些情况下,我们试图训练人工智能得出的答案或正确的输出集通常是正确的。在设计等创造性实践中,没有对错之分。没有正确的输出集。在创意实践中,我们往往对出人意料或不同寻常,甚至是令人不安和具有破坏性的结果感兴趣。那么,在创意实践中解释人工智能模型意味着什么?这种解释与功能性解释和语境有何不同?探索这些问题对更广泛的 XAI 研究有什么启示?

主办:研究生院

承办:设计艺术学院